Héritage de l’ère soviétique, la manipulation de l’information s’est érigée en fer de lance des autorités russes. Les possibilités de falsification se sont multipliées avec l’arrivée de l’intelligence artificielle générative, désormais à la portée du commun des mortel·les depuis quelques années. L’outil permet à n’importe qui de créer du contenu textuel, audio et vidéo pouvant relayer la propagande du Kremlin.

Nous les avons tous rencontrés durant nos balades journalières sur les réseaux sociaux. Des commentaires se glissent dans nos espaces d’échanges et les polluent, avec des réponses souvent incohérentes ou hors-sujet. Ces comptes automatisés pullulent et sont programmés pour rediriger les utilisateur·ices vers des sites malveillants. En janvier 2024, 5th Column, une intelligence artificielle codée par l’organisation de cybersécurité australo-américaine Internet 2.0, a estimé que sur plus d’un million de comptes X analysés, 64% d’entre eux étaient potentiellement des robots. Un chiffre vertigineux pouvant être en partie expliqué par l’existence des usines à trolls russes. Leur but ? Manipuler l’opinion publique en semant désinformation et propagande, comme l’Internet Research Agency d’Evguéni Prigojine, le fondateur du groupe paramilitaire russe Wagner.

Ces faux profils propagent des récits pro-russes à l’aide de comptes relayeurs. Exemple en juillet 2024 : plusieurs utilisateur·ices ont fait circuler une fausse facture d’achat d’une Bugatti valant plus de 4 millions de dollars, au nom de Madame Zelenska, l’épouse du président ukrainien Volodymyr Zelensky, afin de le décrédibiliser.

Un narratif bien ficelé

La Russie, déjà à l’origine de la première ingérence numérique mondiale lors des élections américaines de 2016, n’en est pas à son coup d’essai. « La guerre informationnelle est bien loin du simple soft power, à ce niveau-là on parle d’un autre niveau d’influence », explique Carole Grimaud, chercheuse en sciences de l’information et géopolitique russe. Révélés en février 2024, les documents secrets « Kremlin Leaks » ont dévoilé que le gouvernement russe avait alloué plus de 631 millions d’euros à la guerre de l’information sur l’année 2023. « La désinformation russe existait bien avant l’invasion de l’Ukraine en 2022 », rappelle la chercheuse. « Tout un narratif s’est construit au fil des années, autour d’une soi-disant russophobie orchestrée par la presse occidentale. »

Mais comment justifier cette prolifération de comptes générés par IA sur une plateforme comme X ? La tendance découle de l’accessibilité à l’IA générative, désormais à la portée du grand public, facilitant la création massive de contenu. Le service américain de lutte contre la désinformation NewsGuard a listé 1102 sites d’informations non fiables générés par IA le 15 octobre 2024, c’est-à-dire des pages web sans supervision humaine derrière, soit 1053 de plus qu’en mai 2023. « Nous ne nous attendions pas à une telle augmentation sur une seule année », raconte Chine Labbé, rédactrice en chef du pôle européen de NewsGuard. Parmi les sites répertoriés par le service de lutte contre la désinformation, 15% relayent les récits pro-russes.

Le virtuose pro-russe de l’IA générative

Donner l’accès à l’IA générative permet à n’importe qui d’inonder la toile de propagande russe, comme le témoigne l’incroyable histoire de John Mark Dougan. Cet ancien shérif adjoint s’est reconverti en promoteur du Kremlin après avoir fui les accusations de harcèlement sexuel le visant en 2016. Installé à Moscou, le Floridien a obtenu la nationalité russe en 2023. En parallèle, l’homme a monté son réseau, CopyCop, pour diffuser des discours pro-russe à son échelle. Sa particularité ? L’utilisation de l’IA générative pour monter des sites web d’infox de toutes pièces. Avec cette méthode, John Mark Dougan a réussi à créer 171 fausses pages d’informations comptabilisant 37 millions de vues ! Mais l’ancien shérif a toujours nié être derrière cette opération. Selon David Colon, professeur agrégé, chercheur et historien spécialiste de la propagande, « les acteurs de la propagande bénéficient d’une relative autonomie, à la façon de ce que l’armée appelle « l’art opératif » […] On laisse les acteurs en charge d’une opération, comme CopyCop ou Doppelgänger, le soin de prendre des initiatives sans subir de procédures administratives trop lourdes. »

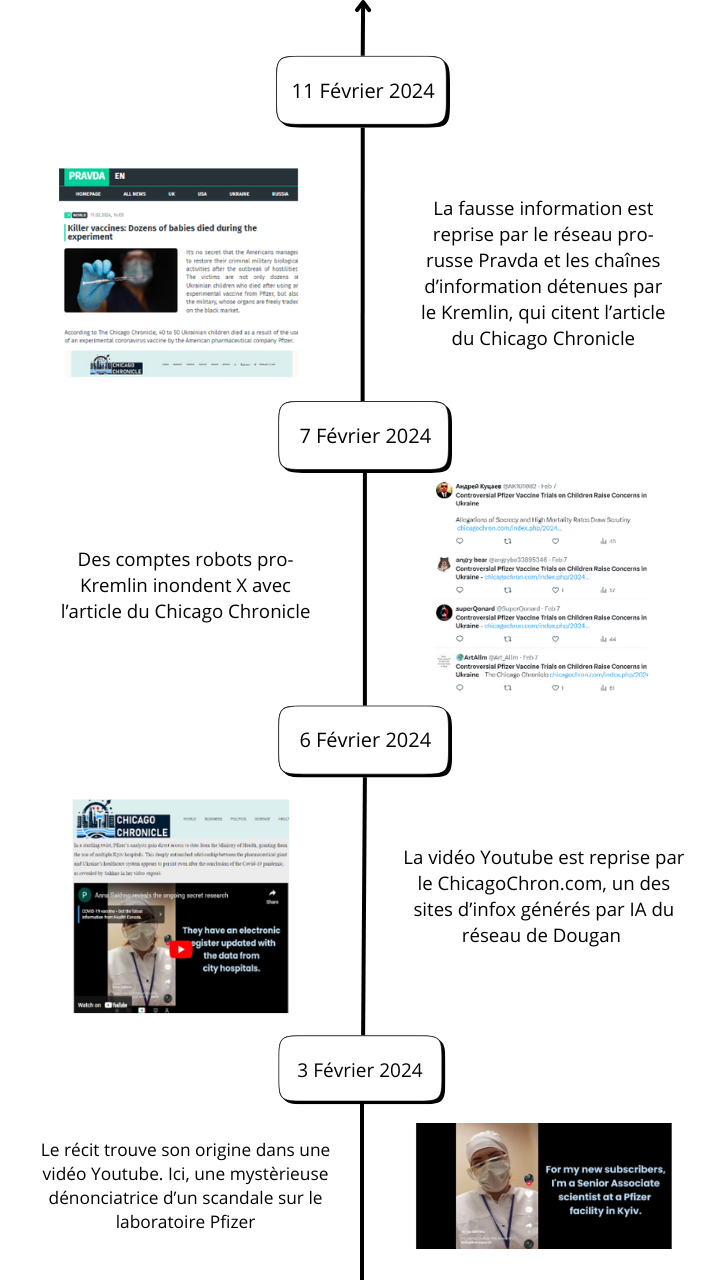

La méthode Dougan est un processus structuré. La diffusion de son récit commence toujours par la publication d’un deepfake sur Youtube. La vidéo trafiquée met en scène un « lanceur d’alerte » qui raconte une histoire en faveur du régime russe. Le discours est ensuite repris sur des faux sites inspirés de véritables médias locaux, via des articles générés et illustrés par IA. Les sites reprennent aussi de vraies informations locales, souvent à caractère polémique, pour authentifier les propos. Les comptes robots se chargent de promouvoir les articles sur les réseaux sociaux, principalement sur X. S’il fonctionne bien, le récit peut se retrouver sur le réseau des portails d’informations de propagande russe tels que « Pravda« , baptisé « Portal Kombat » en février 2024 par le service d’État chargé de la protection contre les ingérences numériques étrangères, dit Viginium, ou encore sur les chaînes de télévision russes par exemple.

La méthode Dougan est un processus structuré. La diffusion de son récit commence toujours par la publication d’un deepfake sur Youtube. La vidéo trafiquée met en scène un « lanceur d’alerte » qui raconte une histoire en faveur du régime russe. Le discours est ensuite repris sur des faux sites inspirés de véritables médias locaux, via des articles générés et illustrés par IA. Les sites reprennent aussi de vraies informations locales, souvent à caractère polémique, pour authentifier les propos. Les comptes robots se chargent de promouvoir les articles sur les réseaux sociaux, principalement sur X. S’il fonctionne bien, le récit peut se retrouver sur le réseau des portails d’informations de propagande russe tels que « Pravda« , baptisé « Portal Kombat » en février 2024 par le service d’État chargé de la protection contre les ingérences numériques étrangères, dit Viginium, ou encore sur les chaînes de télévision russes par exemple.

Quand désinformer devient un jeu d’enfant

Malgré leurs imperfections, le contenu généré par IA de ces sites d’infox russes convainc parfois des internautes peu vigilant·es, ou qui se complaisent aux discours, et finissent par relayer à leur tour de fausses informations. « L’IA générative se perfectionne et fera moins d’erreurs avec le temps, elle sera plus performante d’ici trois ou six mois », assure Chine Labbé. Les activités de John Mark Dougan ont permis de mettre en lumière un autre problème : « Chez NewsGuard, nous avons testé les dix principaux outils d’IA générative à disposition du grand public (ChatGPT, Mistral, Gemini, etc.). Dans 32% des cas, ces derniers citaient les sites ou les deepfakes générés par Dougan comme source ! C’est un cercle vicieux très problématique auquel les industriel·les de l’IA générative doivent s’atteler de toute urgence », s’alarme la rédactrice en chef de NewsGuard Europe. À l’heure où il n’existe encore aucun outil permettant de détecter efficacement les deepfakes et autres créations de l’IA génératives, le travail des journalistes demeure essentiel pour garantir la préservation de la vérité.

Corentin Teissier

La création de sites web, axés sur la désinformation, est à la portée de tous

On commence par déposer un nom de domaine, l’adresse du site web, auprès d’un opérateur, responsable de la gestion, l’enregistrement et la maintenance de ces derniers. Cela peut coûter entre 1 à 10 euros environ, ou même être gratuit selon les services. Ensuite, il faut choisir un hébergeur, une entreprise qui propose un espace de stockage, sous forme de serveur. Pour finir, le système de gestion de contenu (CMS) permet de créer, gérer et d’organiser la structure de son site web. WordPress est le plus connu de tous, notamment en raison de son libre accès. L’IA générative est uniquement utilisée pour générer les contenus qui vont venir garnir le site.