L’opération d’ingérence russe « Matriochka », décelée début 2024, cible directement les journalistes fact-checkeur·ses. Face aux tentatives de manipulation, les rédactions ont dû remettre en cause leur propre rôle. Les acteur·ices du fact-checking doivent maintenant composer avec l’arrivée de l’IA.

Silence feutré à France Médias Monde. L’immeuble en verre d’Issy-les Moulineaux (Hauts-de-Seine) s’active sans bruit. Le son s’étouffe dans les casques, les pas s’amortissent dans la moquette. Les rédactions RFI et France 24 se partagent le deuxième étage du bâtiment. Seuls les clics des souris et les touches des claviers résonnent. Les Observateurs, service d’Osint, l’investigation en sources ouvertes, et de fact-checking de France 24, sont cinq, ce jeudi brumeux d’octobre. Derrière le calme apparent, une menace plane : l’ingérence russe. Ces derniers mois, les journalistes ont directement été attaqué·es. Nom de code : opération « Matriochka ».

Concrètement, de faux contenus sont publiés en usurpant l’identité de médias, de personnalités et de cellules de fact-checking de plusieurs pays, dont la France. « Ça fait bizarre de voir qu’ils ont imité la voix et l’apparence de notre présentatrice », s’étonne Quentin Peschard, journaliste aux Observateurs. Les usurpateur·ices ont notamment recours au deepfake, cette technologie qui permet de reproduire la voix et l’apparence de personnes réelles.

Semer la discorde

Au cours de l’enquête qui révèle l’opération Matriochka, début 2024, l’objectif apparaît de plus en plus clair. La campagne vise à diffuser un narratif pro-russe en décrédibilisant des médias, à l’image du Monde, de BFMTV, de Libération, etc. Elle prend toute sa dimension à travers des vagues de demandes de vérification à destination de fact-checkeur·ses, par mail et sur les réseaux sociaux. « Le but est de nous faire perdre du temps, mais c’est important de traiter la demande quand même, c’est une fausse information en moins sur internet », argumente Claire-Line Nass, journaliste à l’AFP Factuel, le service fact-checking de l’agence.

À l’origine, c’est l’AFP et son service de fact-checking qui dévoile l’affaire. En janvier 2024, AFP Factuel reçoit un signalement du collectif Antibot4Navalny qui fait la chasse aux opérations d’influence russe sur X. Depuis, l’opération Matriochka a été documentée dans un rapport de juin 2024 publié par Viginum, le service de vigilance et de protection contre les ingérences numériques étrangères. L’agence, qui dépend de Matignon, conclut que « la campagne Matriochka, toujours en cours, réunit les critères d’une ingérence numérique étrangère ».

La stratégie est bien connue des chercheur·ses comme David Chavalarias, directeur de recherche au CNRS. « Des acteurs malintentionnés sèment les graines de la discorde parmi nous et obtiennent des résultats concrets » (Toxic data, David Chavalarias, 2023, Flammarion, p.154). Le spécialiste met également en doute la capacité des services de fact-checking à répondre aux vagues de désinformation. L’un de ses collègues, Maxime Audinet, spécialiste de la Russie, est plus nuancé sur l’impact de ces campagnes de désinformation. « Les travaux réalisés depuis 2016 sur l’influence russe vont plutôt dans le sens d’un effet au mieux très limité de la plupart de ces opérations », signale-t-il dans un article de Libération en juillet 2024.

Les Observateurs relativisent aussi l’efficacité de la démarche russe. « La copie de l’identité de France 24 était un peu grossière, avec des formats que l’on ne fait pas. Pour les demandes de vérification, tous les mails se ressemblent », relatent Quentin Peschard et son collègue Nathan Gallo. Les fact-checkeur·ses ont vite pris conscience d’être instrumentalisé·es.

De quoi susciter des interrogations déontologiques. Vérifier cette information, est-ce rentrer dans le jeu de Matriochka ? Faut-il perdre du temps à les traiter ? Parce que oui, « la vérification, c’est chronophage », selon les mots de Derek Thomson, responsable du service des Observateurs. Sur le bureau d’en face, c’est assez limpide pour Nathan Gallo, « on ne vérifie pas tout, car on donne de l’oxygène à des intox qui n’ont pas de grosse audience ».

« On est submergés »

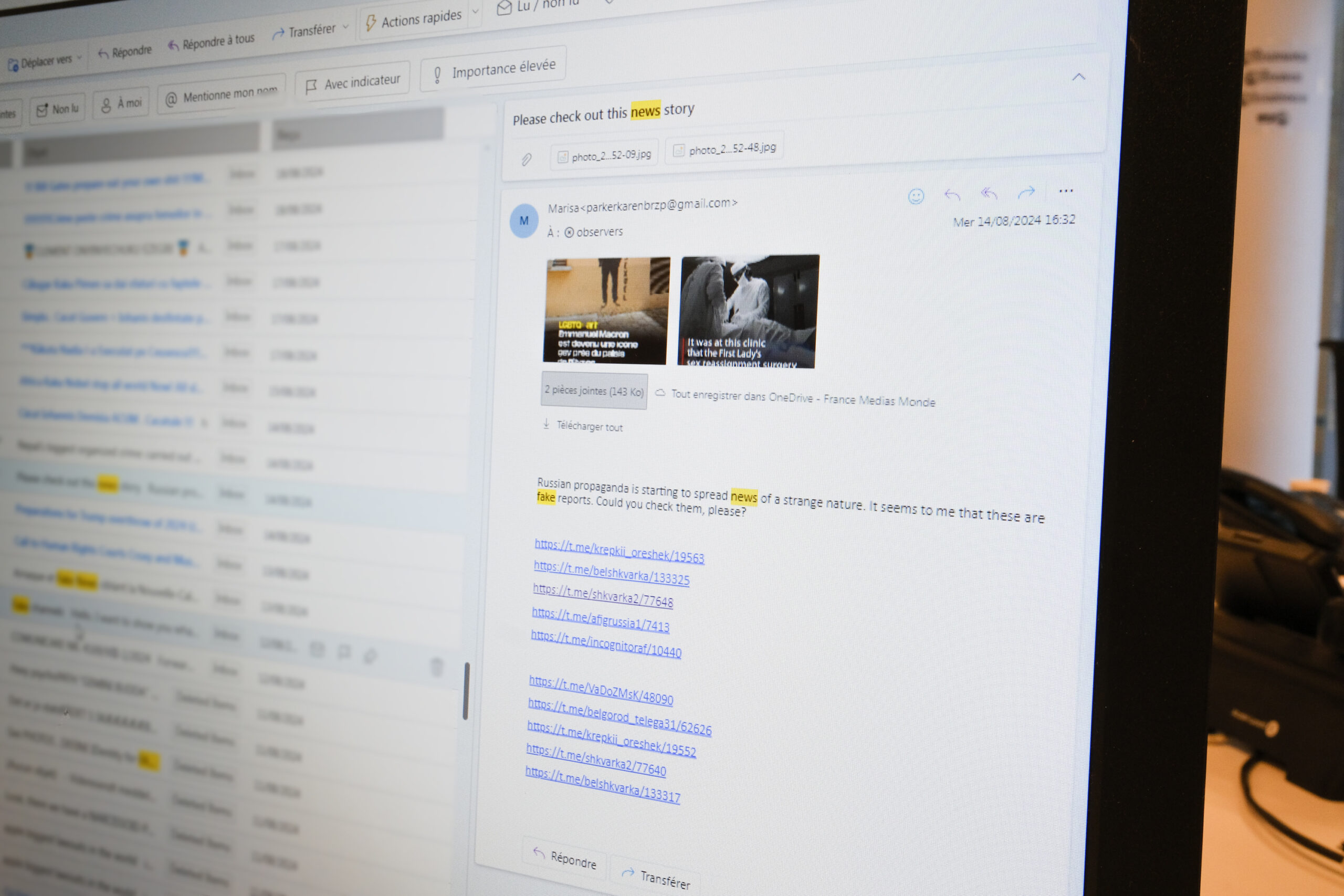

Faute de personnel et donc de temps, tout ne peut pas être traité par les Observateurs. Même constat à l’AFP Factuel. « C’est tellement plus facile de partager une fausse information que de la vérifier. On est submergés. » Témoin de cet afflux de demandes, la boîte mail des Observateurs affiche plus de 27 000 courriers électroniques non lus. Matriochka veut détourner l’attention des fact-checkeur·ses, les empêchant de traiter les informations les plus virales.

À quelques pas de là, dans le sud de Paris, Viginum surveille les activités d’influence russes. C’est dans un café parisien, hors des locaux de leur service, que deux représentantes détaillent la mission de l’organisme. Une cinquantaine d’agent·es passe au peigne fin les réseaux sociaux et internet, pour détecter une « ingérence numérique », c’est-à-dire une opération qui nuit « aux intérêts de la nation ». À partir de sources ouvertes, Viginum tente de mettre la main sur ces campagnes de déstabilisation. « L’efficacité d’une opération n’est pas un critère déterminant pour nous, car c’est difficile à évaluer à chaud », explique Claire Benoît, cheffe de bureau coordination et stratégie à Viginum.

« Les acteurs de l’écosystème pro-russe sont les plus matures, avec le plus d’expérience », poursuit-elle. À travers Matriochka, ces derniers chercheraient à modifier la perception des citoyens au moment des élections. La désinformation n’est pas un flux continu. Elle se fait par vagues, selon les événements. Preuve en est, l’activité s’est accentuée lors des élections européennes et législatives et lors des Jeux olympiques de Paris 2024. « Les manœuvres pro-russe sont aujourd’hui la principale menace qui pèse sur le débat public numérique français. Elles sont quotidiennes, opportunistes, et coordonnées », déclare la cheffe du bureau de coordination et stratégie.

L’IA, poison et antidote

Si l’opération Matriochka n’a pas vraiment déstabilisé les services de fact-checking, l’arrivée de l’intelligence artificielle (IA) pourrait donner un nouvel élan à la désinformation. Les intox deviennent moins coûteuses à produire. Les opérations d’ingérence s’automatisent. « L’intelligence artificielle permet d’industrialiser le processus », indique Claire Benoît. Mais, son explosion n’a pas révolutionné le travail des analystes de Viginum. « Il ne faut pas être alarmiste », balaie l’experte en jouant avec son stylo.

Un peu plus prudent, Nathan Gallo sait bien que les fact-checkeur·ses vont devoir se frotter à l’intelligence artificielle ces prochaines années. Nouveaux outils, nouvelles méthodes de travail… « L’IA complexifie la vérification. » Charge aux journalistes de s’adapter. « Mais, elle n’est pas réservée aux compétiteurs, elle nous permet aussi de développer des outils plus puissants pour lutter contre les ingérences étrangères », s’enthousiasme Claire Benoit. « L’intelligence artificielle, c’est autant le poison que l’antidote face aux ingérences numériques. »

Et sur l’avenir de la désinformation, faut-il tirer la sonnette d’alarme ? « On travaille avec les médias, on contribue à l’éducation… La lutte contre la désinformation s’organise, martèle la coordinatrice de Viginum. On est en train de fédérer un écosystème pour se protéger, je trouve ça encourageant et rassurant. » De là à endiguer les tentatives d’ingérences étrangères, dont la Russie a fait un cheval de bataille depuis quelques années ? À Claire Benoît de l’admettre. « Les acteurs de la désinformation ne vont pas s’essouffler. Il faut être résilient. »

Jules Joué, Quentin Saison et Alexandre Tréhorel

Viginum, la réponse étatique aux ingérences numériques

En 2017, l’entre-deux-tours des présidentielles est perturbé par les « Macron leaks », une fuite de données orchestrée par des agents russes. Pour contrer ces initiatives, le président français décide de lancer, en 2021, le service de vigilance et de protection contre les ingérences numériques étrangères. Viginum vise à « préserver les intérêts de la France ». Une équipe d’une cinquantaine de personnes a pour mission de détecter les ingérences numériques. Ces dernières se définissent selon quatre critères : une intention de porter atteinte aux intérêts de la nation, des contenus trompeurs, un comportement qui correspond à une manœuvre malhonnête, inauthentique et coordonnée et l’implication d’un·e acteur·ice étranger·ère.

Une fois que les quatre critères sont réunis, le service peut conclure à une opération d’ingérence étrangère. Dès lors, Viginum documente la manœuvre et rédige un rapport. Rendu public ou pas, de nombreuses mesures peuvent être prises pour répondre à l’ingérence. En plus de sa mission de documentation des opérations, Viginum sensibilise le public à la vigilance sur internet.

Tout le travail de surveillance se fait en sources ouvertes. Les analystes de Viginum sont, soit des expert·es du numérique, soit des spécialistes du marketing digital, car beaucoup de ces opérations s’appuient sur ces techniques. Il y a une autre équipe : le DataLab. Des professionnel·les développent des outils de surveillance, notamment grâce à l’intelligence artificielle.

En 2023, près de 210 phénomènes ont été détectés et 13 opérations d’ingérences numériques étrangères caractérisées. Pour les Jeux olympiques, l’instance a identifié 43 manœuvres informationnelles visant l’événement entre avril 2023 et septembre 2024.